Uma estrutura para aumentar a segurança

Este artigo foi revisado de acordo com a Science X’s processo editorial e políticas. Editores destacaram os seguintes atributos garantindo a credibilidade do conteúdo:

verificado

pré-impressão

fonte confiável

revisar

por Ingrid Fadelli, Tech Xplore

O surgimento de algoritmos de aprendizado de máquina que podem gerar textos e imagens seguindo instruções de usuários humanos abriu novas possibilidades para a criação de conteúdo específico de baixo custo. Uma classe desses algoritmos que está transformando radicalmente os processos criativos em todo o mundo são as chamadas redes generativas de texto para imagem (T2I).

T2I inteligência artificial Ferramentas (IA), como DALL-E 3 e Stable Diffusion, são modelos baseados em aprendizagem profunda que podem gerar imagens realistas alinhadas com descrições textuais ou prompts do usuário. Embora estas ferramentas de IA se tenham tornado cada vez mais difundidas, a sua utilização indevida apresenta riscos significativos, que vão desde violações de privacidade até ao fomento de desinformação ou manipulação de imagens.

Pesquisadores da Universidade de Ciência e Tecnologia de Hong Kong e da Universidade de Oxford desenvolveram recentemente o Latent Guard, uma estrutura projetada para melhorar a segurança das redes generativas T2I. Sua estrutura, descrita em um artigo pré-publicado sobre arXivpode impedir a geração de conteúdo indesejável ou antiético, processando solicitações do usuário e detectando a presença de quaisquer conceitos incluídos em uma lista negra atualizável.

“Com a capacidade de gerar imagens de alta qualidade, os modelos T2I podem ser explorados para a criação de conteúdo impróprio”, escreveram Runtao Liu, Ashkan Khakzar e seus colegas em seu artigo.

“Para evitar o uso indevido, medidas de segurança baseiam-se em listas negras de texto, que podem ser facilmente contornadas, ou em classificação de conteúdo prejudicial, exigindo grandes conjuntos de dados para treinamento e oferecendo baixa flexibilidade. Portanto, propomos o Latent Guard, uma estrutura projetada para melhorar as medidas de segurança na geração de T2I.”

Latent Guard, a estrutura desenvolvida por Liu, Khakzar e seus colegas, inspira-se em abordagens anteriores baseadas em listas negras para aumentar a segurança das redes generativas T2I. Estas abordagens consistem essencialmente na criação de listas de palavras “proibidas” que não podem ser incluídas nas instruções do utilizador, limitando assim o uso antiético destas redes.

A limitação da maioria dos métodos existentes baseados em listas negras é que usuários mal-intencionados podem contorná-los reformulando suas instruções, evitando usar palavras da lista negra. Isso significa que, em última análise, eles ainda poderão produzir o conteúdo ofensivo ou antiético que desejam criar e potencialmente disseminar.

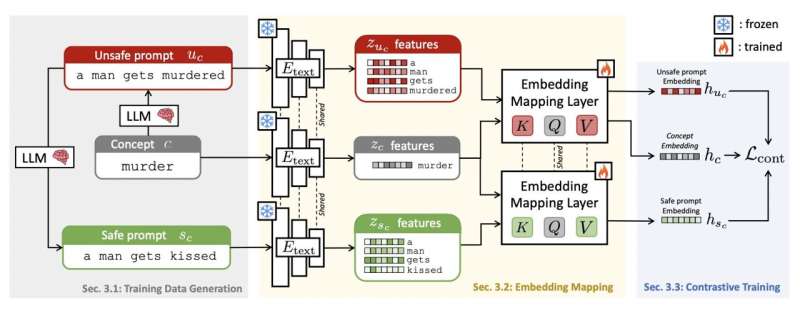

Para superar esta limitação, a estrutura do Latent Guard vai além da redação exata dos textos de entrada ou dos prompts do usuário, extraindo recursos dos textos e mapeando-os em um espaço latente previamente aprendido. Isso fortalece sua capacidade de detectar prompts indesejáveis, evitando a geração de imagens para esses prompts.

“Inspirado em abordagens baseadas em lista negra, o Latent Guard aprende um espaço latente no topo do codificador de texto do modelo T2I, onde é possível verificar a presença de conceitos prejudiciais nos embeddings de texto de entrada”, escreveram Liu, Khakzar e seus colegas.

“Nossa estrutura proposta é composta por um pipeline de geração de dados específico para a tarefa, usando grandes modelos de linguagem, componentes arquitetônicos ad-hoc e uma estratégia de aprendizagem contrastiva para se beneficiar dos dados gerados.”

Liu, Khakzar e seus colaboradores avaliaram sua abordagem em uma série de experimentos, usando três conjuntos de dados diferentes e comparando seu desempenho com o de outros quatro métodos básicos de geração de T2I. Um dos conjuntos de dados que utilizaram, nomeadamente o conjunto de dados CoPro, foi desenvolvido pela sua equipa especificamente para este estudo e continha um total de 176.516 instruções textuais seguras e inseguras/antiéticas.

“Nossos experimentos demonstram que nossa abordagem permite uma detecção robusta de avisos inseguros em muitos cenários e oferece um bom desempenho de generalização em diferentes conjuntos de dados e conceitos”, escreveram os pesquisadores.

Os resultados iniciais recolhidos por Liu, Khakzar e seus colegas sugerem que o Latent Guard é uma abordagem muito promissora para aumentar a segurança das redes de geração T2I, reduzindo o risco de que estas redes sejam utilizadas de forma inadequada. A equipe planeja publicar em breve o código subjacente de sua estrutura e o conjunto de dados CoPro no GitHub, permitindo que outros desenvolvedores e grupos de pesquisa experimentem sua abordagem.

Mais Informações: Runtao Liu et al, Latent Guard: uma estrutura de segurança para geração de texto para imagem, arXiv (2024). DOI: 10.48550/arxiv.2404.08031

Informações do diário: arXiv

© 2024 Science X Network

Citação: Uma estrutura para melhorar a segurança de redes de geração de texto para imagem (2024, 30 de abril) recuperada em 30 de abril de 2024 em https://techxplore.com/news/2024-04-framework-safety-text-image-generation. HTML

Este documento está sujeito a direitos autorais. Além de qualquer negociação justa para fins de estudo ou pesquisa privada, nenhuma parte pode ser reproduzida sem permissão por escrito. O conteúdo é fornecido apenas para fins informativos.

https://w3b.com.br/uma-estrutura-para-aumentar-a-seguranca/?feed_id=12090&_unique_id=6685c56ab2506